یادگیری عمیق

یادگیری عمیق یا یادگیری ژرف (Deep Learning) یکی از زیرشاخههای یادگیری ماشین (Machine Learning) است که بر اساس شبکههای عصبی مصنوعی (Artificial Neural Networks) با چندین لایه (Deep Neural Networks) عمل میکند. این روش با الهام از ساختار مغز انسان، از لایههای متعدد برای استخراج و یادگیری ویژگیها از دادهها استفاده میکند. هر لایه در شبکه عصبی مسئول استخراج ویژگیهای سطح بالاتر از دادهها است که از لایههای پایینتر دریافت میکند. توانایی یادگیری خودکار ویژگیها، بدون نیاز به طراحی دستی ویژگیها، باعث شده است یادگیری عمیق در حل مسائل پیچیده و بزرگ، از جمله پردازش زبان طبیعی، بینایی کامپیوتر، و پیشبینیهای زمانی بسیار موفق باشد.

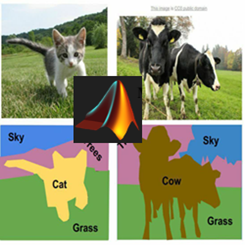

یادگیری عمیق در بسیاری از زمینهها انقلابی ایجاد کرده است. در حوزه بینایی کامپیوتر (Computer Vision)، برای تشخیص چهره (Face Detection)، قطعهبندی تصاویر (Image Segmentation)، و شناسایی اشیاء (Object Detection) استفاده میشود. در پردازش زبان طبیعی (Natural Language Processing – NLP)، کاربردهایی مانند ترجمه ماشینی، تحلیل احساسات، و پاسخ به سؤالات را دارد. همچنین در پزشکی، یادگیری عمیق به منظور تشخیص بیماریها از تصاویر پزشکی، پیشبینیهای ژنتیکی، و تحلیل دادههای زیستی مورد استفاده قرار میگیرد. در زمینههایی مانند خودروهای خودران، سیستمهای توصیهگر (Recommendation Systems)، و بازیهای هوش مصنوعی، یادگیری عمیق نقش حیاتی ایفا میکند و همچنان در حال گسترش به حوزههای جدیدی مانند مهندسی، کشاورزی، و هواشناسی است.

در زیر، برخی از اصلیترین انواع معماری یادگیری عمیق ذکر شدهاند:

1. شبکههای عصبی پیچشی یا کانولوشنی (Convolutional Neural Networks – CNNs)

- ویژگیها:

- مناسب برای پردازش دادههای دو یا سهبعدی (تصاویر یا ویدیوها).

- استفاده از لایههای پیچشی (Convolutional Layers) و تجمیع (Pooling Layers) برای استخراج ویژگیها.

- کاربردها:

- طبقهبندی تصویر: AlexNet، VGG، ResNet.

- تشخیص شیء (Object Detection): Faster R-CNN، YOLO، SSD.

- قطعهبندی تصویر (Semantic Segmentation): U-Net، DeepLabv3، Mask R-CNN.

- بازشناسی فعالیت ویدئویی: C3D، I3D.

- طبقه بندی سیگنال

2. شبکههای عصبی بازگشتی (Recurrent Neural Networks – RNNs)

- ویژگیها: طراحی شده برای پردازش دادههای دنبالهای مانند زمانسریها و متن و توانایی حفظ وضعیت قبلی از طریق گرههای بازگشتی.

- کاربردها: پیشبینی زمانسری، ترجمه ماشینی، تشخیص گفتار.

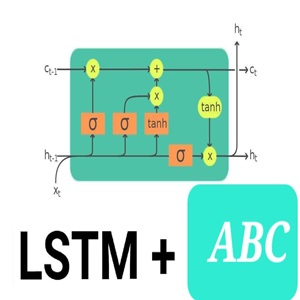

3. شبکههای LSTM و GRU (Long Short-Term Memory و Gated Recurrent Unit)

- ویژگیها: حل مشکل از بین رفتن گرادیان در RNNها و حفظ اطلاعات بلندمدت در طول زمان.

- کاربردها:

- پردازش زبان طبیعی (Natural Language Processing – NLP).

- پیشبینیهای طولانیمدت، طبقه بندی متن و تحلیل سیگنال.

4. شبکههای عصبی مولد (Generative Adversarial Networks – GANs)

- ویژگیها: متشکل از دو شبکه (مولد و تمیزدهنده) که به صورت رقابتی کار میکنند.

- کاربردها: تولید تصاویر واقعی، تقویت دادهها، بهبود کیفیت تصاویر، ویدئوهای ساختگی.

- نمونهها: StyleGAN، CycleGAN، Pix2Pix, DCGAN, cGAN.

5. شبکههای عصبی کپسول (Capsule Networks)

- ویژگیها: تشخیص رابطه بین اجزاء تصاویر (مانند قسمتهای یک شیء) و مقاوم به چرخش و تغییرات.

- کاربردها: تشخیص چهره، بازشناسی اجزاء سهبعدی.

6. شبکههای ترنسفورمر (Transformers)

- ویژگیها:

- استفاده از مکانیسم توجه خودتنظیمی (Self-Attention Mechanism).

- جایگزینی RNNها در بسیاری از وظایف دنبالهای.

- کاربردها:

- پردازش زبان طبیعی (مدلهای BERT و GPT).

- پردازش تصویر و ویدئو (Vision Transformer – ViT).

7. شبکههای عصبی فیزیکی (Physics-Informed Neural Networks – PINNs)

- ویژگیها: حل معادلات دیفرانسیل جزئی و معمولی با استفاده از یادگیری ماشین.

- کاربردها: مدلسازی سیستمهای فیزیکی، شبیهسازی جریان سیال، و شبیهسازیهای علمی.

8. شبکههای عصبی خودتنظیم (Self-Attention Networks)

- ویژگیها: وزندهی به اجزاء مهم دنباله برای افزایش دقت تحلیل و کاربرد گسترده در پردازش زبان و تصاویر.

9. شبکههای تغییرپذیر (Variational Autoencoders – VAEs)

- ویژگیها: نسخهای از Autoencoders با استفاده از توزیعهای احتمالاتی برای تولید دادههای جدید.

- کاربردها: فشردهسازی دادهها، تولید تصاویر.

10. شبکههای عصبی توجهمحور (Attention Mechanism Networks)

- ویژگیها: توانایی تمرکز بر بخشهای مهم دادههای ورودی.

- کاربردها: ترجمه ماشینی، تشخیص گفتار، تحلیل تصاویر.

معماریهای جدیدتر (2020 به بعد):

11. ویژن ترنسفورمر (Vision Transformer – ViT)

- استفاده از معماری ترنسفورمر برای پردازش تصاویر.

12. سویین ترنسفورمر (Swin Transformer)

- معماری کارآمدتر برای پردازش تصاویر و ویدئوها.

13. EfficientNet

- معماری بهینهسازی شده برای پردازش تصاویر با دقت بالا و مصرف منابع کم.

14. ConvNeXt

- بازتعریف CNNها برای رقابت با ترنسفورمرها در پردازش تصاویر.

15. DeepONet

- طراحی شده برای شبیهسازی توابع ریاضی و کاربرد در مسائل علمی.

16. GAN-based Transformers

- ترکیب قابلیتهای GAN و Transformers برای تولید محتوای بهتر.

17. NFNets

- معماری بدون نیاز به نرمالسازی دستهای (Batch Normalization).

18. BigGAN

- نسخه مقیاسپذیرتر و قویتر از GAN برای تولید تصاویر واقعیتر.

19. WaveNet

- طراحی شده برای تولید گفتار طبیعی و موسیقی.

20. Score-Based Generative Models

- تولید دادههای پیچیده با استفاده از معادلات دیفرانسیل تصادفی.

نویسنده: حسن سعادتمند

- بیش از 250 دوره آموزشی در متلب (MATLAB) و پایتون (Python).

- بیش از 15 سال تجربه در زمینه یادگیری ماشین، الگوریتم های فراابتکاری، یادگیری عمیق، مهندسی کنترل.

- چاپ چندین مقاله Q1 در بهترین ژرنال های دنیا Google Scholar.

- مدرس فرادرس

- کانال یوتیوب، کانال اپارت، کانال تلگرام، کانال ایتا

برای اطلاعات بیشتر، میتوانید با نویسنده در تماس باشید.

نمایش 1–9 از 45 نتیجه